| 創澤機器人 |

| CHUANGZE ROBOT |

從斯坦福大學的 VIMA 機器人智能體,到穀歌 DeepMind 推出首個控製機器人的視覺 - 語言 - 動作(VLA)的模型 RT-2,大模型加持的機器人研究備受關注。

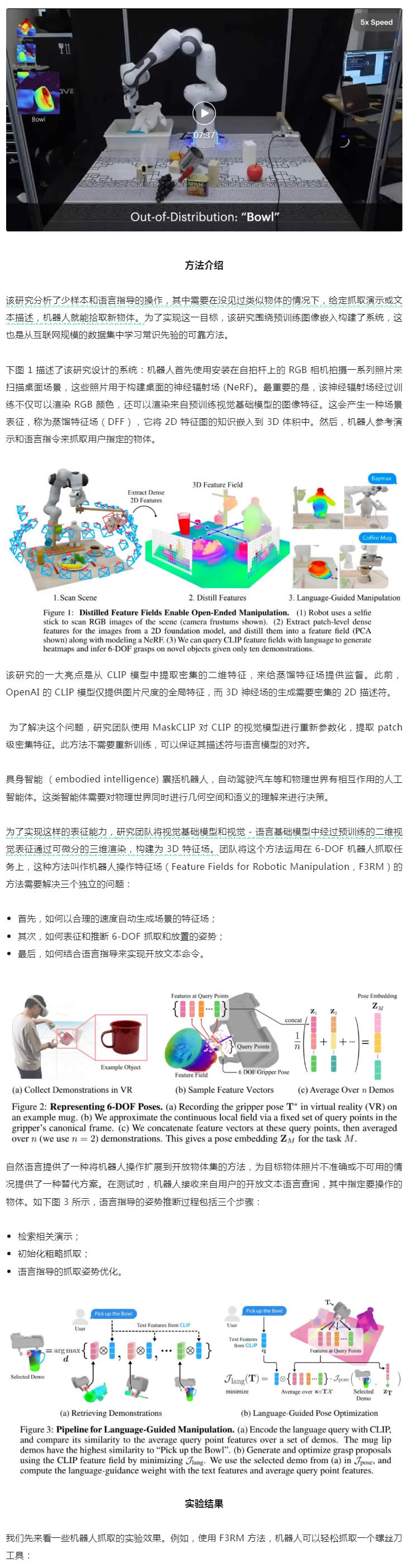

當前,自監督和語言監督的圖像模型已經包含豐富的世界知識,這對於泛化來說非常重要,但圖像特征是二維的。我們知道,機器人任務通常需要對現實世界中三維物體的幾何形狀有所了解。

基於此,來自 MIT CSAIL 和 IAIFI 的研究者利用蒸餾特征場(Distilled Feature Field,DFF),將準確的 3D 幾何圖形與來自 2D 基礎模型的豐富語義結合起來,讓機器人能夠利用 2D 基礎模型中豐富的視覺和語言先驗,完成語言指導的操作。

論文地址:https://arxiv.org/abs/2308.07931

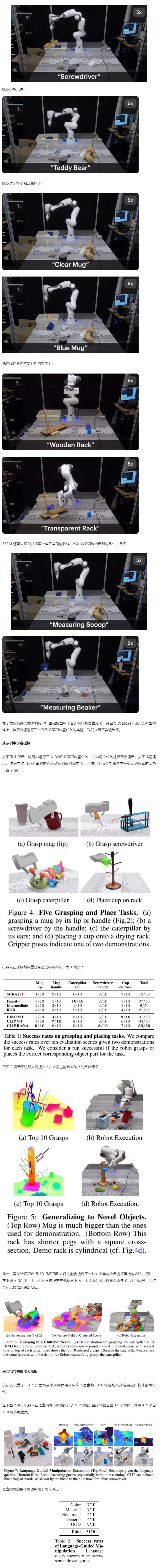

具體來說,該研究提出了一種用於 6-DOF 抓取和放置的小樣本學習方法,並利用強大的空間和語義先驗泛化到未見過物體上。使用從視覺 - 語言模型 CLIP 中提取的特征,該研究提出了一種通過開放性的自然語言指令對新物體進行操作,並展示了這種方法泛化到未見過的表達和新型物體的能力。

研究團隊用一個講解視頻詳細介紹了 F3RM 方法的技術原理:

|

| 機器人底盤Disinfection Robot消毒機器人講解機器人迎賓機器人移動機器人底盤商用機器人智能垃圾站智能服務機器人大屏機器人霧化消毒機器人紫外線消毒機器人消毒機器人價格展廳機器人服務機器人底盤核酸采樣機器人機器人代工廠智能配送機器人噴霧消毒機器人圖書館機器人導引機器人移動消毒機器人導診機器人迎賓接待機器人前台機器人消殺機器人導覽機器人 |