| 創澤機器人 |

| CHUANGZE ROBOT |

機器人通過收集大量觸覺數據來識別物體的方法存在一定的限製。一方麵機器人觸覺傳感器收集大量物體的觸覺數據過程資源耗費大,另一方麵日常生活能接觸到的物體種類龐大。近期在IEEE TRANSACTIONS ON INDUSTRIAL INFORMATICS發表的一篇《A Deep Learning Framework forTactile Recognition of Known as Well as Novel Objects》文章中提出了一種基於卷積神經網絡的綜合觸覺識別框架,它可以利用對象的語義屬性描述和觸覺數據的融合來實現對新對象的識別。相對於傳統學習方法有較大優勢,因為語義信息更容易獲得,可以由人工[1]提供,也可以從語義數據庫(如Wikipedia[2])自動挖掘。

1、機器人觸覺識別總體框架

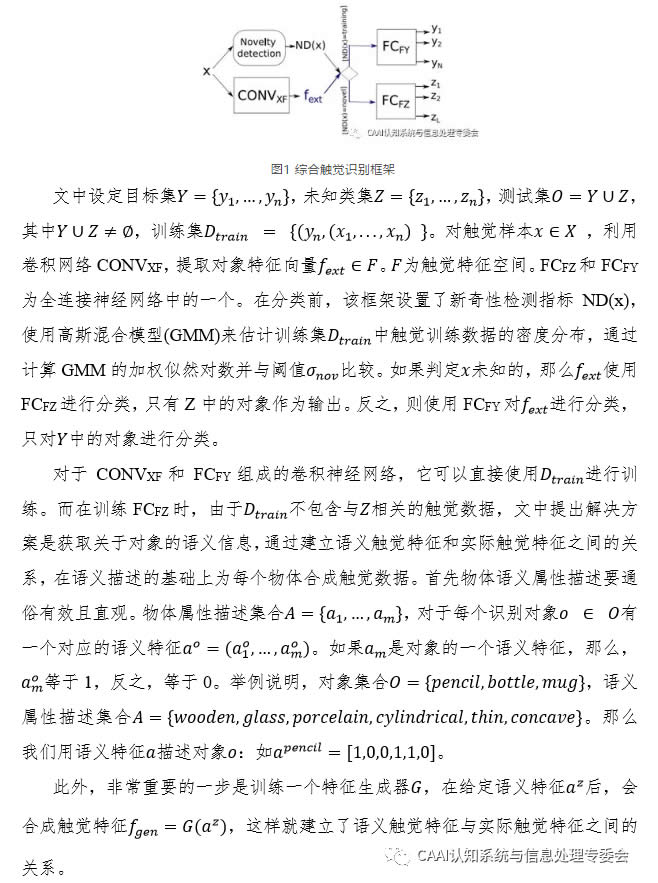

文中設計的總體識別框架,如圖1所示。首先從觸覺數據出發,可以將一個物體識別為一個已知的物體(之前接觸過的)或一個新的物體。已知對象的識別是利用訓練數據構建的多類分類器來實現的,而新奇對象的識別依賴於基於屬性的ZSL方法。此外,通過一次學習(one-shotlearning, OSL),隻從一個訓練樣本開始,就可以實現觸覺數據的合成。

2. 特征生成器G

用訓練集訓練一個包含CONVXF和FCFY的神經網絡CNNXY對Y進行分類。利用語義屬性向量訓練一個反卷積神經網絡G來合成觸覺特征。為提高特征生成器G的品質,使合成的觸覺特征盡可能接近從真實觸覺數據中提取的特征。文中加入另一個卷積神經網絡D來對抗訓練G,其中D用來區分合成觸覺特征或者真實的觸覺特征。利用訓練好的G,合成觸覺特征。

3. 平台搭建

文中使用語義屬性集:A ={吸收性、凹凸性、可壓縮性、冷熱、模糊性、硬的、多毛的、金屬的、多孔的、粗糙的、光滑的、柔軟的、固體的、有彈性的、濕軟的、有紋理的、厚的}。使用公開的PHAC-2數據集,該數據集包含60種物體每一種都在[4]中進行了10次試驗。數據通過SynTouch BioTac觸覺傳感器獲得。對BioTac讀數進行預處理,並按照[5]中使用BioTac讀數對A中包含的屬性進行二元分類,獲得了一個由6000個樣本組成的原始觸覺數據集(60種物體每種10個樣本進行10次試驗)。

文中隨機選擇6個對象作為Z,54個作為Y,為了確保係統對Y和Z選擇具有魯棒性,這個隨機過程重複了七次以生成不同的Z和Y。表1為文中使用的網絡架構。FCFY和FCFZ都是單層全連接網絡。在卷積層之後是針對非線性的ReLU激活函數。卷積層和全連接層的權值都使用Xavier方法[6]進行初始化,所有反卷積層都使用Gaussian初始化器進行初始化。文中用softmax函數和多項式邏輯損失訓練完全連接層,用交叉熵損失訓練D。

4. 實驗評估

1)目標分類

圖2給出了PHAC-2對象及其屬性的例子,以及split 1的測試對象。雖然測試對象(用藍色框起來)在語義上與訓練對象不同,但是這兩個集合共享相同的屬性,每個測試對象都有區別於其他對象的屬性向量。驗證了Z和Y之間的共享屬性,驗證了中每個對象的屬性向量的唯一性,從而允許使用文中框架來執行ZSL。

圖2 PHAC-2對象及其屬性示例

2)已知對象的多重分類

從每個中隨機選取10個樣本作為測試數據,剩下的90個樣本用於訓練CNNXY。表2表示了該框架達到的識別精度。我們可以看到,識別精度是非常高的。這個結果很重要,因為它影響了CONVXF的訓練,從而也影響了對新對象的識別。

表2 的多類分類的識別精度(%)

3)合成觸覺特征的評估

如果缺少真實的訓練數據,則利用合成的特征來訓練識別係統。因此,可以單獨使用合成特征對框架進行訓練並使用真實特征進行測試,以未知目標識別的準確性程度來評估合成觸覺特征的質量。在表3中,測試了在使用真實觸覺特征和使用合成觸覺特征替代真實觸覺特征這兩種情況下,係統的識別表現。

表3 使用每個類0、10、50、90或100個樣本訓練FCFZ後,多類分類(真實觸覺特征訓練)和ZSL(合成觸覺特征)的識別準確率(%)

從表4中很明顯看到,使用真實觸覺特征進行訓練的效果明顯優於合成觸覺特征訓練。但是,在沒有真實觸覺信息可用的情況下,多類分類器是無法區分對象的,會按平均概率進行分類。然而,對於所有的對象分類,ZSL卻可以給出一個高於概率的分類精度。還有,增加訓練的合成觸覺特征樣本數量並不會提高準確度,這可能是因為每個類的合成觸覺特征都是由相同的屬性向量(通過添加少量的噪聲)合成的,這種相似性,為一個對象生成多個特征會導致過擬合。文中還分析了使用對抗神經網絡的必要性,如果跳過算法2和僅使用算法1訓練生成器,那麼係統性能會下降,這是因為合成的觸覺數據與真實觸覺數據有較大差別。

表4有GAN和無GAN的ZSL識別精度(%)

5. 總結

這篇論文設計了一個觸覺識別框架,利用觸覺數據能夠識別已知和未知對象。在對未知對象的識別分類上,精度達到36%,這是傳統訓練模式達不到的。此外,該框架有效利用輸入的數據,如果有足夠的數據可用時,可以達到較高的多類分類精度。該框架仍然存在一些限製,首先領域移位問題[7]和語義屬性空間與觸覺特征空間的相關性限製了對新對象的識別。此外該框架能夠識別的新類集合必須是已知的,添加新類需要修改FCFZ的輸出層,同理添加新屬性需要修改的輸入層。此外,文中使用了由[4]設計的語義二進製屬性。探討非語義屬性和實值屬性可以提高[8]、[9]識別的準確性和泛化能力。最後,文中隻根據觸覺數據來識別物體,可以結合視覺進一步拓展,如在[10],[11]。考慮到CNN在圖像識別和生成[12]方麵的良好表現,視觸覺融合識別可以顯著提高識別性能,這是非常有研究價值的。

|

| 機器人招商Disinfection Robot機器人公司機器人應用智能醫療物聯網機器人排名機器人企業機器人政策教育機器人迎賓機器人機器人開發獨角獸消毒機器人品牌消毒機器人合理用藥地圖 |